Infrastructure d'un datacentre et relocalisation

Phase d'étude

Les sujets à aborder

La conception d'un datacentre se fait au travers d'une phase d'étude longue et complexe. Elle s'étend sur plusieurs années (deux à trois généralement). Lors de cette phase, de nombreux sujets sont étudiés et sont confrontés aux besoins de l'entreprise et à l'état de l'art. La liste suivante présentes les principaux sujets abordés lors d'une phase d'étude:

- le bâtiment (sa forme et sa taille ainsi que le nombre de salles informatiques)

- la consommation et la puissance électrique

- la sécurité physique (les caméras de surveillance, alarmes, barrières, l'accès contrôlé au matériel ainsi que la sécurité du personnel d'administration)

- la liaison avec l'extérieur (type de fibre et contrat opérateur)

- les équipements IT

- les méthodes de refroidissement du matériel informatique

- le câblage des équipements informatiques

- l'infrastructure LAN et SAN

- les applications à héberger

- les bases de données

- le plan de reprise d'activité (PRA ou DRP en anglais pour Disaster Recovery Plan). Ce plan a pour but de définir les actions à réaliser en cas d'arrêt non planifié (sinistre ou acte malintentionné).

Le bâtiment

Bien qu'il héberge plusieurs équipements et fournisse différents services à une entreprise, un datacentre est avant tout un bâtiment. Il est conçu et réfléchi pour fournir une certaine facilité d'accès et pour héberger l'ensemble des équipements informatiques prévus. Il doit aussi répondre à l'ensemble des normes applicables et à des consignes de sécurité strictes.

Lors de la phase d'étude de conception du bâtiment, certaines questions importantes doivent être résolues pour permettre l'avancée du projet:

- le lieu: le bâtiment doit-il être situé en milieu urbain ou rural? Le plus souvent, les entreprises préfèrent situer leurs datacentres à l'extérieur des villes dans un soucis d'économie et pour permettre des accès plus faciles pour l'entrée et la sortie des équipements.

- la superficie: il n'existe pas réellement de limite à ce niveau là. La superficie se calcule en fonction du nombre d'équipements informatiques à installer et du nombre de salles informatiques voulu.

- le nombre de salles informatiques: ces salles ont pour but de contenir l'ensemble des équipements informatiques du datacentre. Leur nombre se détermine en fonction de la superficie maximum d'une salle (superficie fixée par l'entreprise) et du nombre de rangées d'équipements.

- le nombre de rangées d'équipements: tout équipement informatique est contenu dans un rack (sorte d'armoire). Ces racks sont remplis de matériel informatique et alignés tout au long des salles pour maximiser l'occupation de l'espace. Ces rangées de racks sont espacées en suivant des normes (best-practices) bien définies.

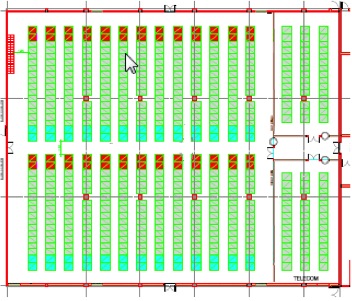

Image de racks alignés

Une fois l'ensemble de ces points déterminés lors de l'étude, il est alors possible de dessiner les plans finaux des salles informatiques et du bâtiment.

Schéma de salle informatique. Chaque colonne représente une rangée de racks et un carré représente un rack. Les carrés rouges et bleus-ciel sont des racks réseau et contienne des commutateurs.

Les équipements informatiques

Les salles informatiques contiennent une multitude d'équipements informatiques rangés dans des racks. Pour rappel, on peut trouver entre autres:

- des serveurs physiques et virtuels (généralement quelques centaines de serveurs physiques et plusieurs milliers de machines virtuelles). Technologie Unix, Windows, Linux, ESX ou encore Citrix.

- des switchs et routeurs

- des baies de stockage

- un ou plusieurs mainframes

- etc...

Lors de la phase de conception, il n'est pas possible de quantifier exactement le nombre d'équipements informatiques nécessaires. Cela doit être calculé en fonction du nombre d'applications à héberger et exécuter, de la puissance nécessaire ou encore du nombre de rangées disponibles. L'objectif est surtout de fournir un premier nombre d'équipements suffisamment important lors de l'ouverture du datacentre pour supporter l'activité.

Le refroidissement

Le refroidissement des datacentres est un élément crucial. Des équipements informatiques mal refroidis surchauffent et tombent souvent en panne. Un bon refroidissement impacte donc directement les performances d'un datacentre.

Il existe deux méthodes principales de refroidissement:

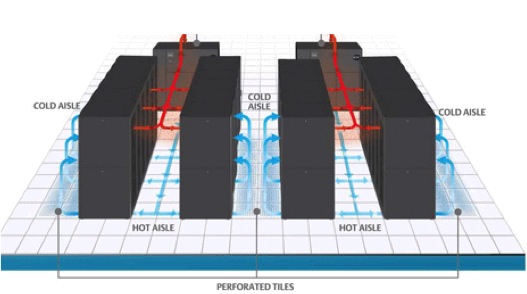

- l'air cooling: cela se base sur une méthode de refroidissement par air en utilisant des climatiseurs répartis dans la salle informatique. Pour que le refroidissement soit optimal, il faut que l'air puisse circuler librement jusqu'aux équipements. C'est pourquoi il existe une logique d'allée chaude/allée froide. L'air frais circule sous le faux-plancher et ressort au niveau des ventilations avants des équipements par le biais de trous percés sur les dalles du faux-plancher. Une fois cet air frais "consommé" par les équipements (l'air est donc devenu plus chaud), il est expulsé par les ventilations arrières. L'ensemble de cet air chaud est ensuite récupéré par les unités de ventilation situés tout au long de la salle pour être refroidi et réinjecté dans le faux plancher. Ces unités de ventilation sont appelés CRAC pour Computer Room Air Conditioner.

Une allée froide correspond aux ventilations avants des équipements de deux rangées mises face à face.

Illustration du air cooling avec les allées froides et chaudes

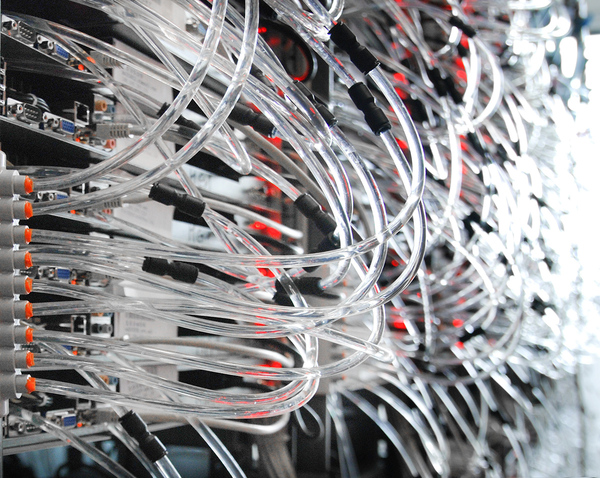

Une allée chaude correspond aux ventilations arrières des équipements de deux rangées mises face à face. - le water cooling: cette méthode est basée sur la circulation d'eau fraiche dans la salle informatique. Des pompes permettent de faire circuler de l'eau depuis des conteneurs jusqu'aux équipements informatiques. Cette eau permet de rafraichir les équipements par le biais de "water blocks". Ces derniers sont attachés aux équipements et reçoivent de l'eau fraiche pour refroidir les équipements, et expulsent ensuite de l'eau plus chaude. Ces eaux expulsées sont récupérées dans des conteneurs qui auront pour tâche de refroidir l'eau avant de la réinjecter dans la salle.

Illustration de l'arrivée d'eau au niveau des racks

On peut aussi compter des solutions plus innovantes, plus respectueuses de l'environnement et plus économiques:

- le free cooling: cette méthode utilise l'air cooling présenté précédemment. Cependant, pour fournir de l'air frais, il utilise la différence de température entre l'intérieur de la salle informatique et l'extérieur du bâtiment. Lorsque la température extérieur est suffisamment faible (au moins 4°C en dessous de la température de la salle), des vannes permettent d'importer l'air extérieur et d'évacuer l'air chaud de la salle. Le free cooling peut aussi être utilisé pour refroidir l'eau utilisé par le water cooling.

Pour utiliser le free cooling, il faut donc que le climat soit favorable. On trouve les meilleures conditions d'utilisation dans les régions souvent enneigées et venteuses. - le water cooling avec des eaux usées

Le câblage des équipements

Le câblage des équipements informatiques est un point crucial dans l'infrastructure d'un datacentre. Lorsqu'il est bien réalisé, il permet de faciliter l'administration et l'ajout (ou le retrait) d'équipements et de ne pas obstruer le flux d'air.

Illustration d'un mauvais cabling. Ici, les ventilations sont totalement obstruées.

Le câblage permet de relier les équipements entre eux et avec le "monde extérieur". Il existe quelques bonnes pratiques permettant de câbler efficacement une salle.

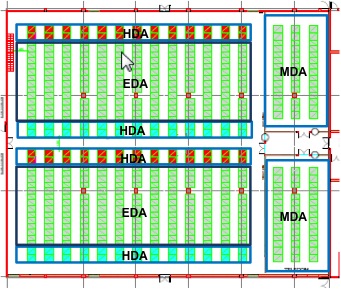

Dans une salle informatique, on compte trois zones principales de câblage:

- la MDA (Main Distribution Area): cette zone correspond au cœur du réseau. Elle contient l'ensemble des routeurs permettant de router les communications à l'intérieur de la salle informatique et vers l'extérieur. Chaque salle informatique possède une MDA.

- la EDA (Equipement Distribution Area): cette zone correspond aux rangées d'équipements informatiques.

- la HDA (Horizontal Distribution Area): cette zone contient l'ensemble des switchs en bordure et assure la communication entre la MDA et la EDA.

Répartition des zones de câblage dans une salle informatique.

De nombreux câbles sont utilisés pour relier l'ensemble de ces zones. Afin d'assurer la sécurité du personnel et pour que les câbles de soient pas accidentellement sectionnés, il faut prévoir plusieurs passages réservés aux câbles. C'est pourquoi l'ensemble de ces câbles sont positionnés dans des chemins de câbles attachés au plafond ou sous le faux-plancher.

Illustration des chemins de câbles au plafond. Ils circulent à l'intérieur des gouttières jaunes.

Détail des chemins de câbles au niveau du plafond.

Les infrastructures LAN et SAN

Les infrastructures LAN et SAN correspondent aux interconnexions de serveurs et baies de stockage. Le réseau LAN est responsable des communications serveur à serveur. Le réseau SAN quant à lui représente un réseau de baies de stockage. Il est nécessaire d'interconnecter ces deux types de réseaux pour permettre les communications serveurs à baies de stockage.

Pour cela, les communications vont reposer sur l'utilisation de deux protocoles:

- Ethernet pour le réseau LAN. Il permet donc de réaliser l'ensemble des communications serveur à serveur

- Fibre channel pour le réseau SAN. Ce protocole nécessite un réseau sans perte et ne peut donc pas utiliser le même support que Ethernet pour les communications.

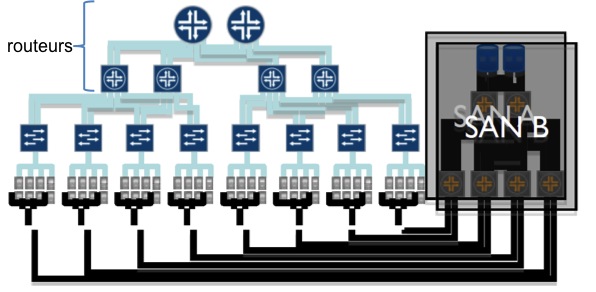

Schéma d'infrastructures LAN et SAN. La partie bleue représente le réseau LAN et la partie noire le réseau SAN. Les routeurs correspondent à la partie MDA ou cœur de réseau. Sous ces routeurs, on trouve les switchs Ethernet interconnectant les serveurs (carrés gris). Les serveurs sont ensuite connectés au réseau SAN grâce aux switchs Fibre Channel.

Le plan de reprise d'activité

Le plan de reprise d'activité (ou PRA) permet à une entreprise d'assurer son activité en cas de crise. Cette continuité est possible en reconstruisant rapidement le système détérioré lors de la crise. Les PRA les plus évolués reposent aussi sur une bascule temporaire sur un système de relève. Par exemple, un datacentre victime d'un incendie verra son activité basculer vers un autre datacentre de l'entreprise capable de maintenir l'activité. Le PRA est donc synonyme d'importants enjeux financiers pour les entreprises dans la mesure où il leur permet d'assurer la prise en charge de leurs besoins informatiques nécessaires à leur survie même en cas de sinistre.

Pour mettre en place un PRA efficace, il faut identifier l'ensemble des applications les plus critiques pour établir le plan de bascule et de reconstruction. Les applications les plus critiques seront bien entendus les premières à être basculées et relancées. Il faut aussi établir le taux de perte minimum de données pour chaque application. En effet, certaines applications critiques n'acceptent que très peu, voire aucune, perte de données dans le cadre de leur activité.

Une fois ces premiers points définis, on obtient une ébauche de PRA avec une liste des applications les plus critiques à basculer et reconstruire.

Le PRA repose aussi essentiellement sur la sauvegarde de données. Ces réplications en continue des données et distribuées sur plusieurs datacentres permettent d'atteindre une haute disponibilité du système, des applications et données. Ces réplications se font à l'aide d'outils proposés par des constructeurs comme VPLEX d'EMC.

Le plan de reprise d'activité défini influe donc sur l'infrastructure des datacentres en prévoyant suffisamment d'espace de stockage pour les réplications et du matériel supplémentaire dans chaque datacentre pour assurer l'activité d'un autre site défaillant en cas de crise.

Si on prend le cas d'une entreprise telle que Google, dont l'activité repose totalement sur son infrastructure informatique, définir un PRA robuste et rapide est une obligation absolue. Une telle entreprise souhaite que son système d'information soit continuellement en marche. En effet, pour Google, des services inactifs entrainent une perte de revenus et d'informations sur ses clients. Les revenus normalement engendrés par les publicités et autres moyens utilisés par Google ne sont pas disponibles à cause de la panne d'un datacentre.

Si on conserve l'exemple de Google, on peut être certain qu'une telle entreprise possède plusieurs datacentres et va donc définir son PRA pour utiliser les performances de l'ensemble de ses bâtiments.

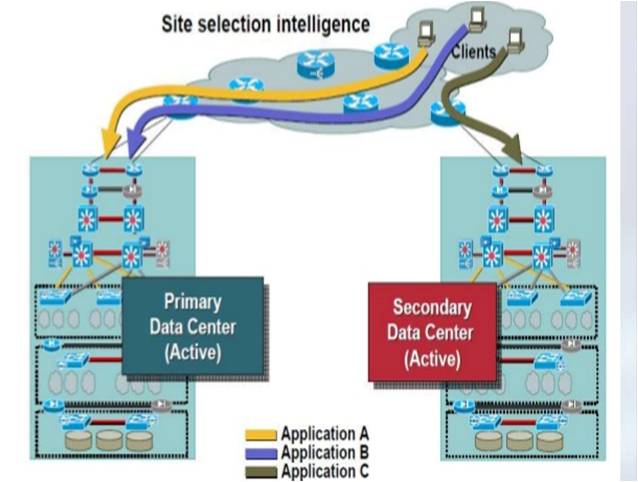

Prenons l'exemple de deux datacentres (un site primaire et un secondaire) et trois applications A, B et C:

Deux datacentres et trois applications

Les utilisateurs, représentés par les clients sur le schéma, seront routés vers l'un ou l'autre des datacentres en fonction des applications auxquelles ils souhaitent accéder. Les trois applications sont accessibles sur n'importe quel datacentre. Cependant, dans sa politique de performances, l'entreprise décide que les applications A et B ne seront accessibles que depuis le datacentre primaire et C que depuis le secondaire. Les données de chaque application sont cependant répliquées entre chaque site.

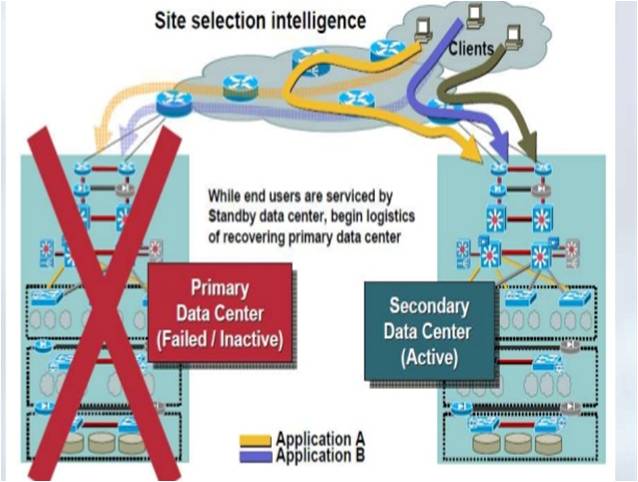

Admettons maintenant que le datacentre primaire soit tombé pour cause d'incendie par exemple:

Un datacentre tombe

Une absence de PRA empêchera donc les utilisateurs d'accéder aux applications A et B puisqu'elles ne sont normalement accessibles que depuis le site primaire (qui est maintenant hors service).

Un PRA bien défini permet par contre à l'entreprise de continuer son activité. En effet, les applications sont hébergées sur les deux sites et les données sont continuellement répliquées. Il ne suffit "plus" que d'effectuer un re-routage automatique des utilisateurs vers le second site et activer les applications sur le datacentre secondaire.

Une telle solution technique peut reposer sur l'utilisation d'outils tels que Vmware vMotion pour permettre aux applications de naviguer d'un site vers un autre, EMC VPLEX pour la réplication des données entre deux datacentres et BGP pour le re-routage.