GPU Computing CUDA

Présentation de l'API CUDA

Composant de l'API

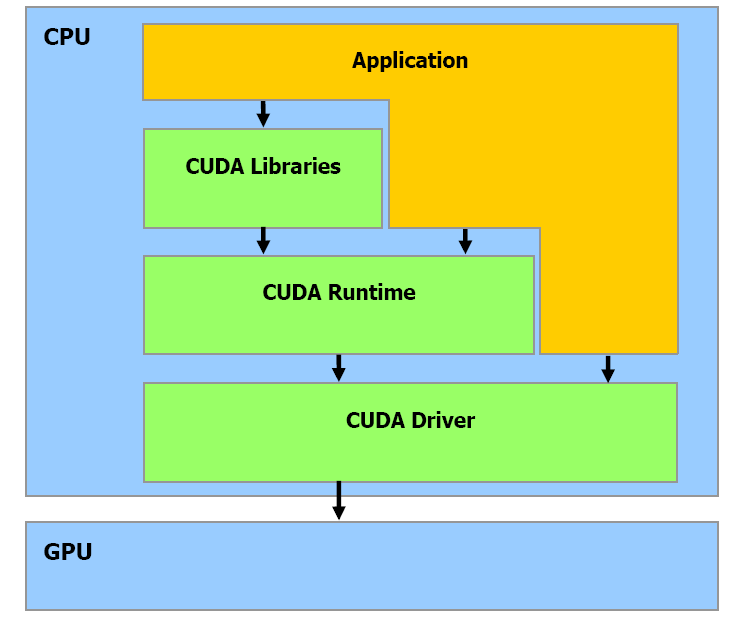

L'API CUDA se compose en trois parties :

- Runtime : C'est l'interface entre le GPU et l'application, en fournissant quelques automatismes.

- Driver : Son rôle est de transmettre les calculs de l'application au GPU.

- Librairies : CUDA est livré avec les implémentations de l'algorithme BLAS et FFT, optimisée pour cette architecture.

Vocabulaire

Un certain vocabulaire est associé au developpement sur GPU, je vais vous en faire la liste dans les lignes suivantes.

|

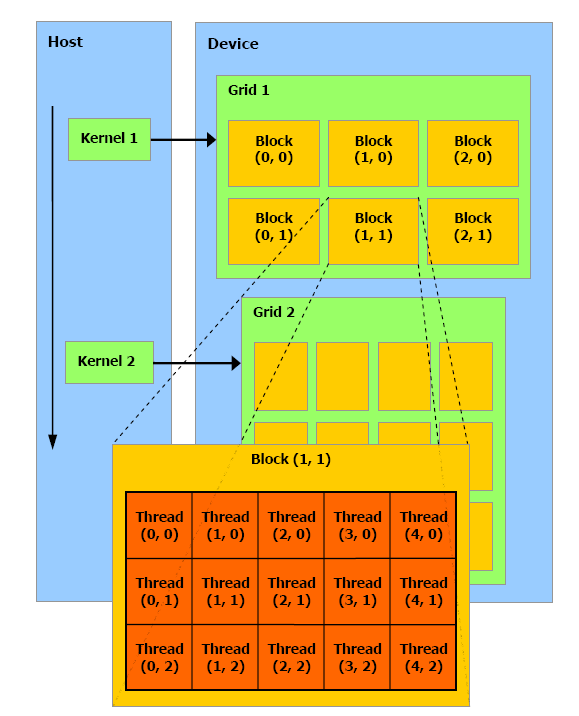

donc pas être exécutés dans un certain ordre : parallèlement, consécutivement ou toute autre combinaison est possible. C'est pourquoi les threads ne peuvent communiquer qu'avec des threads du même bloc. Un thread est exécuté par un processeur : posons donc l'égalité entre le thread et le processeur. Ainsi, le bloc est le multiprocesseur, tandis que la grille représente l'entièreté de la carte. |

Modèle d'exécution

Ancien Modèle SIMD(single instruction, multiple data):

- On applique à un ensemble de données la même opération

- Changement de repère sur un élément

Nouveau Modèle SIMT(single instruction, multiple thread) :

- On exécute des bouts de code à un ensemble de données simultanément.